Fakey-pelin kuvat. Mihai Avram ja Filippo Menczer

Fakey-pelin kuvat. Mihai Avram ja Filippo Menczer

Sosiaalinen media on joukossa tärkeimmät uutiset Yhdysvalloissa ja kaikkialla maailmassa. Kuitenkin käyttäjät altistuvat kyseenalaisen tarkkuuden sisällölle, mukaan lukien salaliittoteorioita, clickbait, hyperpartisaanin sisältö, pseudotiede ja jopa "väärennetyt uutiset" -raportit.

Ei ole yllättävää, että on julkaistu niin paljon väärää tietoa: roskapostia ja verkkopetoksia ovat kannattavia rikollisillesekä hallituksen ja poliittisen propagandan tuotto sekä puolueellisia että taloudellisia etuja. Mutta se, että alhaisen uskottavuuden sisältö leviää niin nopeasti ja helposti ehdottaa, että ihmiset ja sosiaalisen median alustojen taustalla olevat algoritmit ovat alttiita manipuloinnille.

Tutkimuksemme on havainnut kolme erilaista harhaa, jotka tekevät sosiaalisen median ekosysteemin haavoittuvaisiksi sekä tahalliselta että tahattomalta väärinkäytöltä. Siksi meidän Sosiaalisen median observatorio Indiana-yliopistossa rakennetaan työkalut auttaa ihmisiä tietämään nämä puolueettomuudet ja suojelemaan itseään niiden hyödyntämiseen tarkoitetuilta ulkopuolisilta vaikutuksilta.

Selvitä sosiaalisen median observatoriossa kehitetyt työkalut:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Bias aivoissa

Kognitiiviset puolueet syntyvät siitä, miten aivot käsittelevät tietoja, joita jokainen ihminen kohtaa päivittäin. Aivot voivat käsitellä vain rajallista määrää tietoa, ja liian monet saapuvat ärsykkeet voivat aiheuttaa tietojen ylikuormitus. Sillä on itsessään vakavia seurauksia sosiaalisen median tietojen laadulle. Olemme havainneet, että käyttäjien rajoitetusta huomiosta kohdistuva jyrkkä kilpailu tarkoittaa sitä jotkut ajatukset menevät virukseksi heikkolaatuisuudesta huolimatta - jopa silloin, kun ihmiset haluavat jakaa korkealaatuista sisältöä.

Välttääksesi hukkua, aivot käyttävät a temppuja. Nämä menetelmät ovat yleensä tehokkaita, mutta voivat myös tulla puolueettomiksi kun sitä käytetään väärissä yhteyksissä.

Yksi kognitiivinen pikakuvake tapahtuu, kun henkilö päättää, haluatko jakaa tarinan, joka näkyy niiden sosiaalisen median syötössä. Ihmiset ovat otsakkeen emotionaaliset merkitykset vaikuttavat hyvin, vaikka se ei ole hyvä indikaattori artikkelin tarkkuudesta. Paljon tärkeämpää on joka kirjoitti kappaleen.

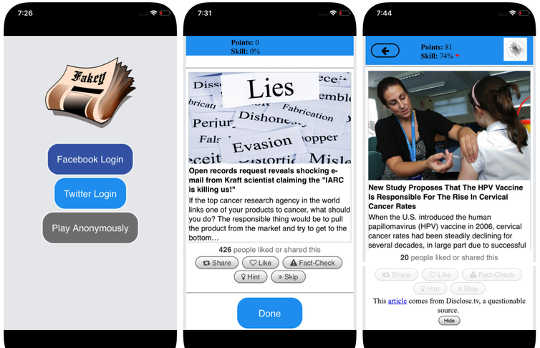

Kehitimme tätä puolueellisuutta vastaan ja autamme ihmisiä kiinnittämään enemmän huomiota väitteen lähteeseen ennen sen jakamista Fakey, mobiili uutisten lukutaidon peli (ilmainen Android ja iOS) simuloimalla tyypillistä sosiaalisen median uutissyötettä, jossa on joukko uutisartikkeleita valtavirran ja matalan uskottavuuden lähteistä. Pelaajat saavat enemmän pisteitä uutisten jakamisesta luotettavista lähteistä ja epäilyttävän sisällön merkitsemisestä tosiasioiden tarkistamiseen. Prosessissa he oppivat tunnistamaan lähteiden uskottavuuden signaalit, kuten hyperpartisaaniset vaatimukset ja emotionaalisesti veloitetut otsikot.

Bias yhteiskunnassa

Toinen ennakkoluulon lähde on yhteiskunnalta. Kun ihmiset muodostavat yhteyden suoraan ikäisensä, heidän ystäviensä valintaa ohjaavat sosiaaliset puolueet vaikuttavat heidän näkemiinsä tietoihin.

Itse asiassa tutkimuksessamme olemme havainneet, että se on mahdollista määrittää Twitter-käyttäjän poliittiset kallistukset katsomalla yksinkertaisesti ystäviensä puolueellisia mieltymyksiä. Meidän analyysi näiden rakenteesta puolueelliset viestintäverkot sosiaaliset verkostot ovat erityisen tehokkaita tiedon levittämisessä - tarkkana tai ei - milloin ne ovat tiiviisti sidoksissa toisiinsa ja irrotettu muista yhteiskunnan osista.

Suuntaus arvioida tietoja suotuisammin, jos se tulee oman sosiaalisen piirinsä kautta, luo ”kaikuhuoneet”Jotka ovat kypsiä manipulointiin joko tietoisesti tai tahattomasti. Tämä auttaa selittämään, miksi niin monet online-keskustelut siirtyvät ”Meitä vastaan” vastakkainasetteluja.

Selvitimme, miten online-sosiaalisten verkostojen rakenne tekee käyttäjistä haavoittuvaisiksi desinformaatiolle Hoaxy- järjestelmä, joka seuraa ja visualisoi sisällön leviämistä matalan uskottavuuden lähteistä ja miten se kilpailee tosiasiallisen sisällön kanssa. Analyysi Hoaxy'n keräämistä tiedoista Yhdysvaltain presidentinvaalien 2016 aikana osoittaa, että Twitter-tilejä, jotka ovat jakaneet väärää tietoa, olivat lähes kokonaan katkaistu todentajien tekemistä korjauksista.

Kun porasimme alas väärää tietoa levittävistä tileistä, löysimme erittäin tiheän ydinryhmän, joka toisti toisiaan melkein yksinomaan - mukaan lukien useita robotteja. Aina kerta, kun tietojenkäsittelyorganisaatiot mainitsivat tai mainitsivat väärin informoidussa ryhmässä, ne olivat kyseenalaistaneet heidän legitiimiytensä tai väittäneet vastakohtaa niiden kirjoittamalle.

Bias koneessa

Kolmas ryhmä esijännityksiä syntyy suoraan algoritmeista, joita käytetään määrittämään, mitä ihmiset näkevät verkossa. Sekä sosiaalisen median alustat että hakukoneet käyttävät niitä. Nämä yksilöintitekniikat on suunniteltu valitsemaan vain kaikkein kiinnostavin ja tärkein sisältö jokaiselle käyttäjälle. Näin tehdessään se voi kuitenkin vahvistaa käyttäjien kognitiivisia ja sosiaalisia puolueita, mikä tekee niistä entistä haavoittuvammat manipuloinnille.

Esimerkiksi yksityiskohtaiset mainosvälineet, jotka on rakennettu moniin sosiaalisen median alustoihin anna väärinkäyttäjien hyväksikäytön vahvistusvinouma by räätälöidä viestejä ihmisille, jotka ovat jo taipuvaisia uskomaan heitä.

Lisäksi, jos käyttäjä napsauttaa usein Facebook-linkkejä tietystä uutislähteestä, Facebook tulee osoittavat, että kyseinen henkilö on enemmän kyseisen sivuston sisällöstä. Tämä ns.suodattimen kupla”Vaikutus voi eristää ihmisiä erilaisista näkökulmista, vahvistamalla vahvistuksen harhaa.

Omat tutkimukset osoittavat, että sosiaalisen median järjestelmät altistavat käyttäjille vähemmän erilaisia lähteitä kuin ei-sosiaalisen median sivustot, kuten Wikipedia. Koska tämä on koko alustan tasolla, ei yksittäisen käyttäjän tasolla, kutsumme tätä homogeenisuus.

Toinen tärkeä sosiaalisen median ainesosa on tiedot, jotka ovat trendien mukaisia alustan mukaan sen mukaan, mitä saa eniten napsautuksia. Me kutsumme tätä suosiota, koska olemme havainneet, että suosittujen sisältöjen edistämiseen suunniteltu algoritmi voi vaikuttaa kielteisesti alustan tietojen yleiseen laatuun. Tämä lisää myös olemassa olevia kognitiivisia puolueita ja vahvistaa sitä, mikä on suosittu sen laadusta riippumatta.

Kaikki nämä algoritmiset puolueet voidaan manipuloida sosiaaliset botit, tietokoneohjelmat, jotka ovat vuorovaikutuksessa ihmisten kanssa sosiaalisen median tilien kautta. Useimmat sosiaaliset robotit, kuten Twitter Big Ben, ovat vaarattomia. Jotkut kuitenkin peittävät todellisen luonteensa ja niitä käytetään haitallisiin tarkoituksiin, kuten väärinkäytön lisääminen tai väärin luodaan ruohonjuuritason liike, jota kutsutaan myös "astroturfiksi." Löysimme todisteita tällaisesta manipuloinnista 2010 USA: n puolivälin vaaleissa.

Näiden manipulointistrategioiden tutkimiseen kehitimme työkalun, jolla havaitaan kutsutut sosiaaliset robotit Botometer. Botometri käyttää koneen oppimista tunnistamaan bot-tilejä tarkastamalla tuhansia Twitter-tilien erilaisia ominaisuuksia, kuten sen viestien aikoja, kuinka usein se twiittii, ja tilejä, joita se seuraa ja uudelleen. Se ei ole täydellinen, mutta se on paljastanut, että niin monta kuin 15-prosenttiosuus Twitter-tileistä osoittaa merkkejä botista.

Analysoimme väärän informaatioverkon ytimen 2016: n USA: n presidentinvaalikampanjan aikana käyttäen Botometria yhdessä Hoaxy-ohjelman kanssa. Löysimme monia botteja, jotka käyttivät sekä uhrien kognitiivisia, vahvistus- ja suosiohyökkäyksiä että Twitterin algoritmisia puolueita.

Nämä botit pystyvät rakentamaan suodatinkuplia haavoittuvien käyttäjien ympärille, syöttämällä heille vääriä väitteitä ja väärää tietoa. Ensinnäkin ne voivat houkutella sellaisten käyttäjien käyttäjiä, jotka tukevat tiettyä ehdokasta tweeting-ehdokkaan hahmoja tai mainitsemalla ja uudelleenhahmottamalla. Sitten botit voivat vahvistaa väärennettyjä väitteitä, jotka tuovat vastustajia uudelleenkirjoittamalla artikkeleita matalan uskottavuuden lähteistä, jotka vastaavat tiettyjä avainsanoja. Tämä toiminto tekee myös algoritmista korostuksen muille käyttäjille, joita käytetään väärin tarinoita, joita jaetaan laajalti.

Monimutkaisten haavoittuvuuksien ymmärtäminen

Vaikka tutkimuksemme ja muutkin osoittavat, miten yksilöitä, instituutioita ja jopa koko yhteiskuntaa voidaan manipuloida sosiaalisen median avulla monia kysymyksiä jätetty vastaamaan. Erityisen tärkeää on selvittää, miten nämä eri puolueet vaikuttavat toisiinsa ja jotka voivat luoda monimutkaisempia haavoittuvuuksia.

Meidän kaltaiset työkalut tarjoavat internetin käyttäjille enemmän tietoa väärinkäytöksistä ja siten jonkin verran suojaa sen vahingoista. Ratkaisut tulevat olemaan ei todennäköisesti ole vain teknistä, vaikka niihin liittyy todennäköisesti joitakin teknisiä näkökohtia. Mutta heidän on otettava huomioon kognitiiviset ja sosiaaliset näkökohdat ongelmasta.

Tietoja kirjoittajista

Giovanni Luca Ciampaglia, apulais tutkija, Indiana University Network Network Institute, Indiana University ja Filippo Menczer, tietojenkäsittelytieteen ja informatiikan professori; Monimutkaisten verkkojen ja järjestelmätutkimuksen keskuksen johtaja, \ t Indiana University

Tämä artikkeli julkaistiin alunperin Conversation. Lue alkuperäinen artikkeli.

Liittyvät kirjat

at

Kiitos käynnistä InnerSelf.com, missä niitä on 20,000+ elämää muuttavat artikkelit, joissa mainostetaan "Uusia asenteita ja uusia mahdollisuuksia". Kaikki artikkelit on käännetty kielelle Yli 30 kieltä. Tilaa viikoittain ilmestyvälle InnerSelf Magazinelle ja Marie T Russellin Daily Inspirationille. InnerSelf-lehti on julkaistu vuodesta 1985.

Kiitos käynnistä InnerSelf.com, missä niitä on 20,000+ elämää muuttavat artikkelit, joissa mainostetaan "Uusia asenteita ja uusia mahdollisuuksia". Kaikki artikkelit on käännetty kielelle Yli 30 kieltä. Tilaa viikoittain ilmestyvälle InnerSelf Magazinelle ja Marie T Russellin Daily Inspirationille. InnerSelf-lehti on julkaistu vuodesta 1985.