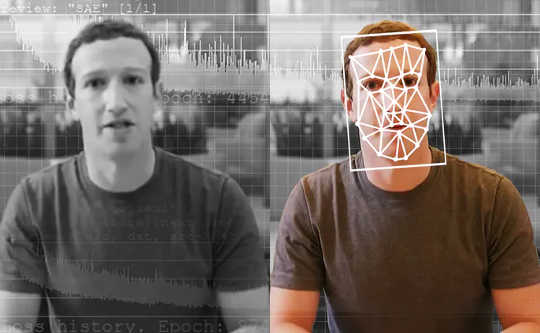

Tekoälyllä toimivat ilmaisimet ovat parhaat työkalut tekoälyn tuottamien väärennettyjen videoiden havaitsemiseen. Washington Postin kautta Getty Images

Tutkiva toimittaja saa videon nimettömältä ilmiantajalta. Se osoittaa, että presidenttiehdokas myöntää laitonta toimintaa. Mutta onko tämä video todellinen? Jos näin on, se olisi valtava uutinen - kauhu koko elämästä - ja se voisi kääntyä täysin tulevien vaalien ympäri. Mutta toimittaja suorittaa videon erikoistuneella työkalulla, joka kertoo hänelle, että video ei ole miltä se näyttää. Itse asiassa se ondeepfake, Video, joka on tehty tekoälyä käyttäen syvä oppiminen.

Toimittajat ympäri maailmaa voisivat pian käyttää tällaista työkalua. Muutaman vuoden kuluttua kaikki voivat jopa käyttää tällaista työkalua väärennetyn sisällön kitkemiseksi sosiaalisen median syötteistään.

As Tutkijat jotka ovat tutkineet syväväärennösten havaitsemista ja kehitämme työkalua toimittajille, näemme tulevaisuuden näille työkaluille. Ne eivät kuitenkaan ratkaise kaikkia ongelmiamme, ja ne ovat vain yksi osa arsenaalia laajemmassa disinformaation torjunnassa.

Syväväärennösten ongelma

Useimmat ihmiset tietävät, että et voi uskoa kaikkea, mitä näet. Viimeisen vuosikymmenen aikana tajujen uutisten kuluttajat ovat tottuneet näkemään kuvia, joita on manipuloitu valokuvien muokkausohjelmalla. Videot ovat kuitenkin toinen tarina. Hollywoodin ohjaajat voivat käyttää miljoonia dollareita erikoistehosteisiin muodostaakseen realistisen kohtauksen. Mutta syväväärennösten avulla harrastajat, joilla on muutama tuhat dollaria tietokonelaitteita ja muutama viikko viettää, voivat tehdä jotain melkein yhtä totta elämästä.

Deepfakesin avulla ihmiset voidaan sijoittaa elokuviin, joissa he eivät koskaan olleet - ajattele Tom Cruise pelaa Iron Mania - mikä tekee viihdyttävistä videoista. Valitettavasti se mahdollistaa myös luomisen pornografia ilman suostumusta kuvatuista ihmisistä. Toistaiseksi nuo ihmiset, melkein kaikki naiset, ovat suurimmat uhrit, kun syvävaletekniikkaa käytetään väärin.

Deepfake-tiedostoja voidaan käyttää myös videoiden luomiseen poliittisista johtajista, jotka sanovat asioita, joita he eivät ole koskaan sanoneet. Belgian sosialistipuolue julkaisi heikkolaatuisen, mutta silti väärennetyn videon Presidentti Trump loukkaa Belgiaa, joka sai tarpeeksi reaktion osoittamaan korkealaatuisempien väärennösten mahdolliset riskit.

{vembed Y = poSd2CyDpyA}

Kalifornian yliopisto, Berkeleyn Hany Farid kertoo kuinka syvävalheita tehdään.

Ehkä pelottavin kaikista, niitä voidaan käyttää luomiseen epäillä todellisten videoiden sisältöä, ehdottamalla, että ne voivat olla syväpetoksia.

Nämä riskit huomioon ottaen olisi erittäin arvokasta pystyä havaitsemaan syväpetokset ja merkitä ne selvästi. Näin varmistettaisiin, että väärennetyt videot eivät huijata yleisöä ja että todelliset videot voidaan vastaanottaa aitona.

Väärennösten havaitseminen

Deepfake-havaitseminen tutkimusalana aloitettiin hieman yli kolme vuotta sitten. Varhainen työ keskittyi havaitsemaan videoissa näkyviä ongelmia, kuten syväväärennökset, jotka eivät vilku. Ajan myötä väärennökset ovat parantuneet todellisten videoiden jäljittelemisessä, ja niiden on vaikeampi havaita sekä ihmisille että tunnistustyökaluille.

On olemassa kaksi pääryhmää syväväärennösten havaitsemiseen. Ensimmäiseen liittyy katsomalla ihmisten käyttäytymistä videoissa. Oletetaan, että sinulla on paljon videoita joku kuuluisa, kuten presidentti Obama. Tekoäly voi käyttää tätä videota oppimaan hänen kuvionsa, käsiliikkeistä puhepausiin. Se voi sitten katsella syvää väärennöstä hänestä ja huomaa, missä se ei vastaa näitä malleja. Tällä lähestymistavalla on se etu, että se toimii mahdollisesti, vaikka videon laatu itsessään olisi olennaisesti täydellinen.

{vembed Y = gsv1OsCEad0}

SRI Internationalin Aaron Lawson kuvaa yhtä lähestymistapaa syvän väärennösten havaitsemiseen.

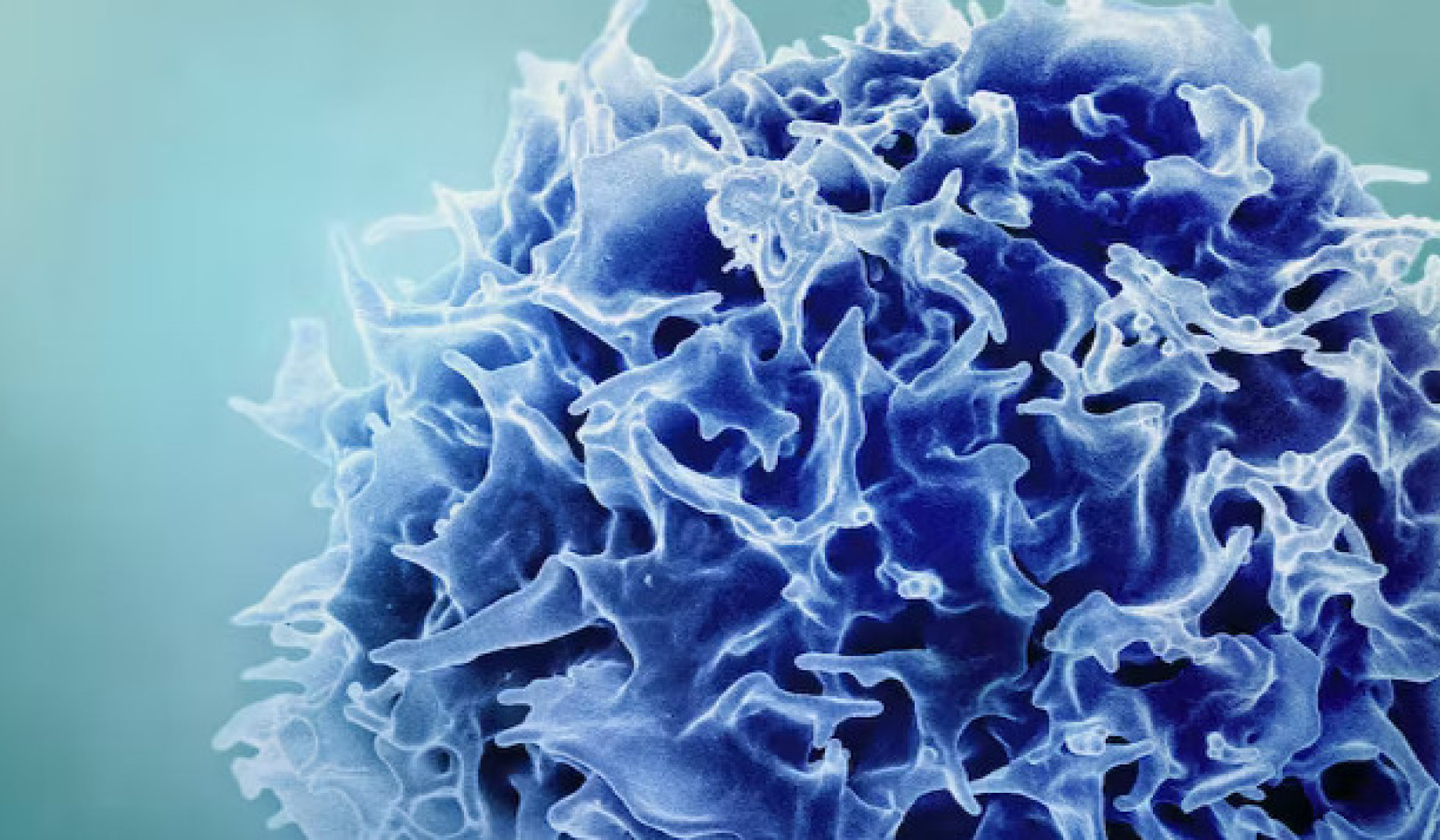

Muut tutkijat, mukaan lukien tiimimme, ovat keskittyneet erot että kaikilla syväfakeilla on verrattuna todellisiin videoihin. Deepfake-videot luodaan usein yhdistämällä yksilöllisesti kehitetyt kehykset videoiksi. Kun tämä otetaan huomioon, tiimimme menetelmät poimivat olennaiset tiedot videon kasvojen yksittäisistä kehyksistä ja seuraavat ne sitten samanaikaisten kehysten sarjoilla. Tämän avulla voimme havaita epäjohdonmukaisuuksia tiedonkulussa kehyksestä toiseen. Käytämme samanlaista lähestymistapaa myös väärennetyn äänentunnistusjärjestelmän kanssa.

Näitä hienovaraisia yksityiskohtia on vaikea nähdä ihmisille, mutta ne osoittavat kuinka syväväärennökset eivät ole aivan täydellinen vielä. Tällaiset ilmaisimet voivat toimia kaikille ihmisille, ei vain harvoille maailman johtajille. Loppujen lopuksi voi olla, että tarvitaan molempia syväfake-ilmaisimia.

Viimeaikaiset tunnistusjärjestelmät toimivat erittäin hyvin videoissa, jotka on kerätty erityisesti työkalujen arviointia varten. Valitettavasti jopa parhaat mallit tekevät huonosti verkossa löydetyistä videoista. Näiden työkalujen parantaminen vakaammiksi ja hyödyllisemmiksi on avain seuraava askel.

Kenen tulisi käyttää syväfake-ilmaisimia?

Ihannetapauksessa deepfake-vahvistustyökalun pitäisi olla kaikkien saatavilla. Tämä tekniikka on kuitenkin alkuvaiheessa. Tutkijoiden on parannettava työkaluja ja suojattava hakkereilta, ennen kuin heidät vapautetaan laajasti.

Samalla kuitenkin työkalut syväväärennösten tekoon ovat kaikkien saatavilla, jotka haluavat huijata yleisöä. Vieressä istuminen ei ole vaihtoehto. Tiimimme kannalta oikea tasapaino oli työskennellä toimittajien kanssa, koska he ovat ensimmäinen puolustuslinja väärän tiedon leviämistä vastaan.

Ennen tarinoiden julkaisemista toimittajien on tarkistettava tiedot. Heillä on jo kokeiltuja menetelmiä, kuten tarkistaminen lähteistä ja useamman kuin yhden henkilön saaminen vahvistamaan tärkeimmät tosiasiat. Joten antamalla työkalun heidän käsiinsä annamme heille enemmän tietoa, ja tiedämme, että he eivät luota pelkästään tekniikkaan, koska se voi tehdä virheitä.

Voivatko ilmaisimet voittaa asevarustelun?

On rohkaisevaa nähdä joukkueita Facebook ja Microsoft investoimalla tekniikkaan syvien väärennösten ymmärtämiseksi ja havaitsemiseksi. Tämä ala tarvitsee lisää tutkimusta pysyäkseen syväfake-tekniikan kehityksen vauhdissa.

Toimittajien ja sosiaalisen median alustojen on myös selvitettävä, kuinka parhaiten varoittaa ihmisiä syväväärennöksistä, kun ne havaitaan. Tutkimukset ovat osoittaneet sen ihmiset muistavat valheen, mutta ei tosiasia, että se oli valhe. Onko sama totta myös väärennetyissä videoissa? Pelkkä "Deepfake" -otsikon lisääminen otsikkoon ei välttämättä riitä torjumaan tietyntyyppistä disinformaatiota.

Deepfakes ovat täällä jäädäkseen. Disinformaation hallinta ja yleisön suojeleminen ovat haastavampia kuin koskaan, kun tekoäly tehostuu. Olemme osa kasvavaa tutkimusyhteisöä, joka ottaa vastaan tämän uhan, jossa havaitseminen on vasta ensimmäinen askel.![]()

Tietoja Tekijät

John Sohrawardi, tietojenkäsittelytieteen tohtoriopiskelija, Rochester Institute of Technology ja tietotekniikan professori Matthew Wright, Rochester Institute of Technology

Tämä artikkeli julkaistaan uudelleen Conversation Creative Commons -lisenssin alla. Lue alkuperäinen artikkeli.