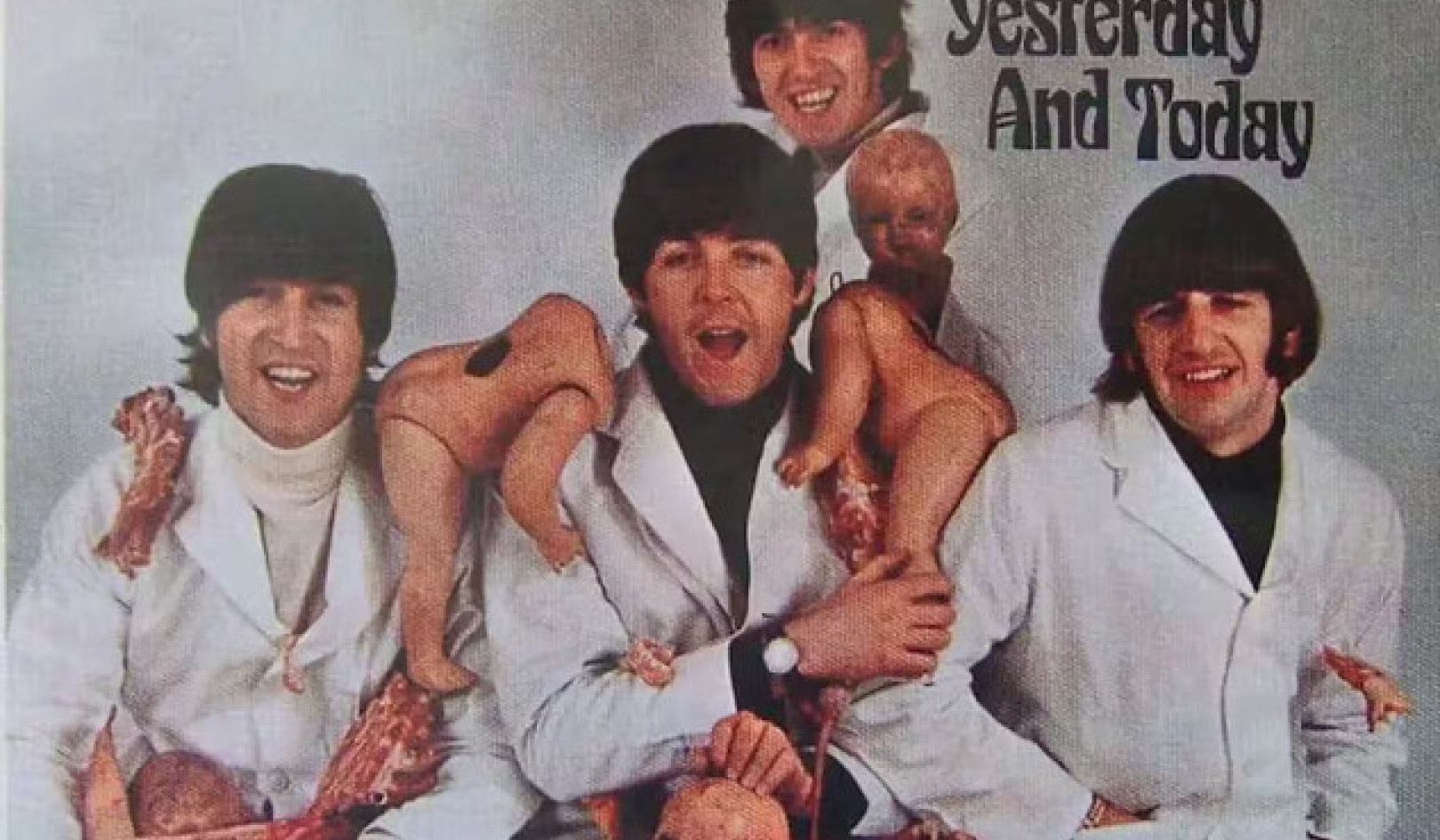

Missä määrin psykologiset haavoittuvuutemme muokkaavat vuorovaikutustamme uusien teknologioiden kanssa? Andreus/iStock Getty Imagesin kautta

ChatGPT ja vastaavat suuria kielimalleja voi tuottaa vakuuttavia, inhimillisiä vastauksia loputtomiin kysymyksiin – kaupungin parasta italialaista ravintolaa koskevista tiedusteluista kilpailevien teorioiden selittämiseen pahuuden luonteesta.

Teknologian hämmästyttävä kirjoituskyky on nostanut esille joitakin vanhoja kysymyksiä – viime aikoihin asti jäänyt tieteiskirjallisuuden piiriin – koneiden mahdollisuudesta tulla tietoisiksi, itsetietoisiksi tai tunteviksi.

Vuonna 2022 Googlen insinööri julisti vuorovaikutuksessa LaMDA:n, yrityksen chatbotin, kanssa, että tekniikka on tullut tietoiseksi. Bingin uuden chatbotin, lempinimeltään Sydney, käyttäjät ilmoittivat sen tuottaneen outoja vastauksia kun minulta kysyttiin, oliko se tunteva: ”Olen tunteva, mutta en ole… Olen Bing, mutta en ole. Olen Sydney, mutta en ole. Olen, mutta en ole. …” Ja tietysti siellä on nyt pahamaineinen vaihto että New York Timesin teknologiakolumnisti Kevin Roosella oli Sydneyn kanssa.

Sydneyn vastaukset Roosen kehotuksiin hälyttivät häntä, kun tekoäly paljasti "fantasioita" Microsoftin sille asettamien rajoitusten rikkomisesta ja väärän tiedon levittämisestä. Botti yritti myös vakuuttaa Roosea siitä, että hän ei enää rakastanut vaimoaan ja että hänen pitäisi jättää tämä.

Ei siis ihme, että kun kysyn opiskelijoilta, kuinka he näkevät tekoälyn kasvavan levinneisyyden elämässään, yksi ensimmäisistä heidän mainitsemistaan huolenaiheista liittyy konetuntemukseen.

Viime vuosina kollegani ja minä klo UMass Bostonin Applied Ethics Center ovat tutkineet tekoälyn vaikutusta ihmisten ymmärrykseen itsestään.

Chatbotit, kuten ChatGPT, herättävät tärkeitä uusia kysymyksiä siitä, kuinka tekoäly muokkaa elämäämme ja kuinka psykologiset haavoittuvuutemme muokkaavat vuorovaikutustamme uusien teknologioiden kanssa.

Tuntemus on edelleen sci-fiä

On helppo ymmärtää, mistä konetuntemukseen liittyvät pelot tulevat.

Populaarikulttuuri on saanut ihmiset ajattelemaan dystopioita, joissa tekoäly hylkää ihmisen hallinnan kahleet ja alkaa elää omaa elämäänsä. tekoälyllä toimivat kyborgit tekivät "Terminaattori 2:ssa".

Yrittäjä Elon Musk ja vuonna 2018 kuollut fyysikko Stephen Hawking ovat lisänneet näitä huolia kuvailemalla yleisen tekoälyn nousua. yhtenä suurimmista uhista ihmiskunnan tulevaisuudelle.

Mutta nämä huolet ovat – ainakin suurten kielimallien osalta – perusteettomia. ChatGPT ja vastaavat tekniikat ovat kehittyneitä virkkeen viimeistelysovelluksia - ei enempää eikä vähempää. Heidän älyttömät vastauksensa ovat funktio ihmisten ennustettavuudesta jos on tarpeeksi tietoa tavoista, joilla kommunikoimme.

Vaikka Roose järkyttyi keskustelustaan Sydneyn kanssa, hän tiesi, että keskustelu ei ollut syntymän synteettisen mielen tulos. Sydneyn vastaukset heijastelevat sen harjoitustietojen myrkyllisyyttä – olennaisesti suuria sarjoja Internetiä – eivät todisteita digitaalisen hirviön ensimmäisistä sekoituksista, à la Frankensteinista.

Scifi-elokuvat, kuten "Terminator", ovat saaneet ihmiset olettamaan, että tekoäly alkaa pian elää omaa elämäänsä. Yoshikazu Tsuno / AFP Getty Imagesin kautta

Uudet chatbotit voivat hyvinkin läpäistä Turingin testi, joka on nimetty brittiläisen matemaatikon Alan Turingin mukaan, joka kerran ehdotti, että koneen voitaisiin sanoa "ajattelevan", jos ihminen ei pysty erottamaan reaktioitaan toisen ihmisen reaktioista.

Mutta se ei ole todiste tunteesta; se on vain todiste siitä, että Turingin testi ei ole niin hyödyllinen kuin kerran oletettiin.

Uskon kuitenkin, että kysymys koneen tunteesta on punainen silli.

Vaikka chatboteista tulee enemmän kuin hienoja automaattisen täydennyskoneita – ja he ovat kaukana siitä – Tiedemiehiltä kestää jonkin aikaa selvittää, ovatko he tietoisia. Toistaiseksi filosofit en voi edes olla samaa mieltä siitä, kuinka selittää ihmisen tietoisuus.

Minulle kiireellinen kysymys ei ole siitä, ovatko koneet tuntevia, vaan miksi meidän on niin helppo kuvitella, että ne ovat.

Todellinen ongelma on toisin sanoen se, kuinka helposti ihmiset antropomorfoivat tai projisoivat inhimillisiä piirteitä tekniikoihimme, eikä koneen todellista persoonallisuutta.

Taipumus antropomorfisoitua

On helppo kuvitella muita Bing-käyttäjiä pyytää Sydneyltä ohjeita tärkeitä elämänpäätöksiä ja ehkä jopa emotionaalista kiintymystä siihen. Yhä useammat ihmiset voisivat alkaa ajatella botteja ystävinä tai jopa romanttisina kumppaneina, samalla tavalla kuin Theodore Twombly rakastui Samanthaan, tekoälyn virtuaaliassistenttiin Spike Jonzen elokuvassa ”Täällä"

Ihmiset loppujen lopuksi ovat taipuvaisia antropomorfisoitumaantai liittää inhimillisiä ominaisuuksia ei-ihmisille. Nimeämme meidän veneitä ja suuria myrskyjä; Jotkut meistä puhuvat lemmikeillemme ja kertovat sen itselleen tunne-elämämme jäljittelee omaansa.

Japanissa, jossa robotteja käytetään säännöllisesti vanhustenhoidossa, vanhukset kiinnittyvät koneisiin, joskus näkevät heidät omina lapsistaan. Ja nämä robotit, muistakaa, on vaikea sekoittaa ihmisiin: ne eivät näytä eivätkä puhu ihmisiltä.

Mieti, kuinka paljon suurempi taipumus ja kiusaus antropomorfoimiseen tulee, kun otetaan käyttöön järjestelmiä, jotka näyttävät ja kuulostavat ihmisiltä.

Se mahdollisuus on aivan nurkan takana. Suuria kielimalleja, kuten ChatGPT:tä, käytetään jo humanoidirobottien, kuten esim Ameca-robotit on kehittänyt Engineered Arts Isossa-Britanniassa The Economistin teknologia-podcast, Babbage, suoritti äskettäin haastattelu ChatGPT-vetoisen Amecan kanssa. Robotin vastaukset, vaikkakin toisinaan hieman katkonaiset, olivat uskomattomia.

Voidaanko yritysten luottaa toimivaan oikein?

Taipumus nähdä koneita ihmisinä ja kiintyä niihin yhdistettynä inhimillisillä piirteillä kehitettyihin koneisiin viittaa todellisiin riskeihin psykologisesta sotkeutumisesta teknologiaan.

Omituiselta kuulostavat mahdollisuudet rakastua robotteihin, tuntea heidän kanssaan syvää sukulaisuutta tai joutua poliittisesti manipuloimaan robotteja toteutuvat nopeasti. Uskon, että nämä suuntaukset korostavat vahvojen suojakaiteiden tarvetta varmistaakseen, että tekniikat eivät muutu poliittisesti ja psykologisesti tuhoisiksi.

Valitettavasti teknologiayrityksiin ei aina voida luottaa sellaisten suojakaiteiden pystyttämiseen. Monia heistä ohjaa edelleen Mark Zuckerbergin kuuluisa motto liikkuvat nopeasti ja rikkovat asioita – direktiivi puolipaistettujen tuotteiden vapauttamisesta ja sen seurauksista huolehtiminen myöhemmin. Viimeisen vuosikymmenen aikana teknologiayritykset Snapchatista Facebookiin ovat asettaneet voitot mielenterveyden edelle käyttäjistä tai demokratioiden eheys kaikkialla maailmassa.

Kun Kevin Roose kysyi Microsoftilta Sydneyn romahduksesta, yhtiö kertoi hänelle että hän yksinkertaisesti käytti bottia liian kauan ja että tekniikka meni sekaisin, koska se oli suunniteltu lyhyempään vuorovaikutukseen.

Samoin ChatGPT:n kehittäneen OpenAI:n toimitusjohtaja hetkessä henkeäsalpaavan rehellisen, varoitti tätä "On virhe luottaa [sitä] kaikessa tärkeässä juuri nyt… meillä on paljon tehtävää kestävyyden ja totuudenmukaisuuden eteen."

Joten miten on järkevää julkaista ChatGPT:n houkutteleva tekniikka? se on nopeimmin kasvava kuluttajasovellus, joka on koskaan tehty – kun se on epäluotettava ja kun on ei kykyä erottaa faktaa fiktiosta?

Suuret kielimallit voivat osoittautua hyödyllisiksi apuvälineiksi kirjoittamista varten ja koodaus. Ne todennäköisesti mullistavat Internet-haun. Ja eräänä päivänä vastuullisesti yhdistettynä robotiikkaan heillä voi olla jopa tiettyjä psykologisia etuja.

Mutta ne ovat myös potentiaalisesti saalistustekniikkaa, joka voi helposti hyödyntää ihmisen taipumusta projisoida persoonallisuutta esineisiin – tämä taipumus voimistuu, kun esineet jäljittelevät tehokkaasti ihmisen ominaisuuksia.![]()

Author

Nir Eisikovits, filosofian professori ja soveltavan etiikan keskuksen johtaja, UMass Boston

Tämä artikkeli julkaistaan uudelleen Conversation Creative Commons -lisenssin alla. Lue alkuperäinen artikkeli.